Curso Universitario de Especialización en Big Data para Ingenierías

225 Horas, 9 Créditos ECTS | Formato Online

250€

115€

Descripción General del Curso | E-learning

El Curso Universitario de Especialización en Big Data para Ingenierías es una formación académica diseñada para proporcionar a los estudiantes los conocimientos y habilidades necesarios para desarrollarse en el campo del análisis y gestión de grandes volúmenes de datos. Este curso se centra en la aplicación de técnicas y herramientas específicas del Big Data para resolver problemas reales en el ámbito de las ingenierías.

Además, los estudiantes adquirirán habilidades fundamentales en estadística y análisis de datos que les permitirán comprender y aplicar técnicas avanzadas de minería de datos y aprendizaje automático. A lo largo del curso, también se abordarán temas clave como la visualización de datos y la seguridad en el procesamiento de big data.

El programa de este curso incluye una combinación equilibrada de teoría y práctica. Los participantes tendrán la oportunidad de trabajar en casos de estudio y proyectos reales, aplicando los conocimientos adquiridos a situaciones del mundo real. Además, contarán con el apoyo de profesores expertos y recibirán una constante retroalimentación para mejorar sus habilidades y conocimientos.

Al finalizar el Curso Universitario de Especialización en Big Data para Ingenierías, los estudiantes estarán preparados para enfrentar los desafíos y aprovechar las oportunidades que el análisis de big data ofrece en el ámbito de las ingenierías. Su perfil profesional se verá fortalecido y tendrán las competencias necesarias para trabajar en empresas y organizaciones que requieran expertos en el manejo y análisis de grandes volúmenes de datos.

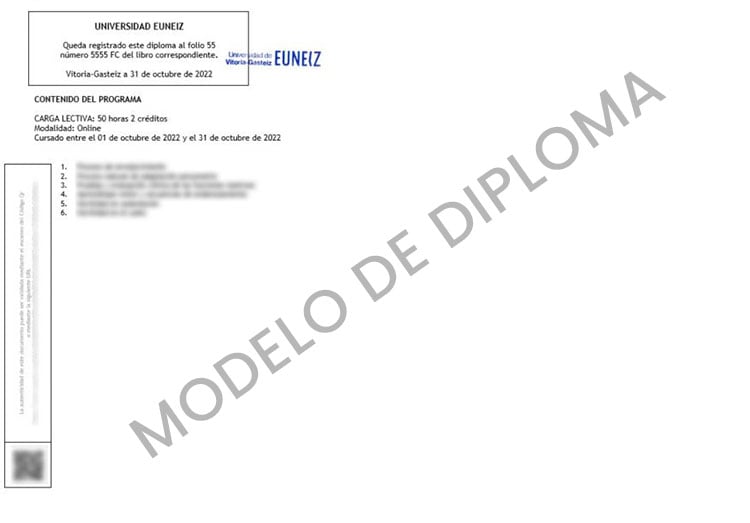

Acreditado por Universidad de Vitoria-Gasteiz

Nuestros programas académicos cuentan con la acreditación universitaria otorgada por European University Gasteiz (EUNEIZ), una institución de renombre en el ámbito educativo europeo. Esta acreditación asegura que los contenidos y la metodología de enseñanza de nuestros Cursos, Expertos, Especialistas y Máster de Formación Permanente cumplen con los estándares académicos y profesionales establecidos por EUNEIZ.

Los diplomas emitidos bajo la acreditación de la Universidad Vitoria-Gasteiz confirman que el estudiante ha completado satisfactoriamente un programa de estudio que cumple con los criterios de calidad educativa europea. Además, cada diploma cuenta con la firma del Rector y un Código de Verificación único. Al acceder al enlace proporcionado en el diploma e introducir este código, los estudiantes pueden verificar fácilmente la autenticidad y la validez académica del título obtenido.

Modelo del Diploma

La Universidad de Vitoria-Gasteiz (EUNEIZ) es una nueva universidad privada, oficialmente reconocida según la Ley 8/2021, de 11 de noviembre (BOE – BOPV). EUNEIZ se encuentra plenamente integrada en el Sistema Universitario Vasco y se dedica a brindar educación superior a través de la docencia, investigación, formación continua y la transferencia de conocimiento y tecnología.

La Universidad de Vitoria-Gasteiz y Universal Formación, buscamos potenciar aún más nuestra oferta educativa al proporcionar programas formativos online de alta calidad y acreditados universitariamente. Esta alianza representa una oportunidad única para nuestros estudiantes y para el avance de la educación en línea en un entorno cada vez más digital y globalizado.

Título expedido

Una vez finalice su programa formativo le será expedido el Diploma de la Universidad de Vitoria-Gasteiz, este documento que le mostramos a continuación sería su modelo:

Empieza tu formación en Arquitectura Técnica de Forma Flexible y 100% Online

Estudia desde casa, a tu ritmo, y organiza tu tiempo según tus necesidades personales o profesionales. Una opción ideal para compaginar con el trabajo, la conciliación familiar u otros estudios, con la tranquilidad de contar con acceso ilimitado a todos los contenidos durante toda tu matrícula.

Inicio del Curso

La inscripción en este programa formativo está abierta hasta final de plazas y durante presente año

Carga Horaria

225 Horas, 9 Créditos ECTS

Todos los alumnos inscritos en este Curso en línea tendrán 6 meses de acceso libre al Campus Virtual y todos sus contenidos E-learning.

Puntuable y Baremable

Este Curso cuenta con certificación, lo cual hace que sea válido para bolsas y oposiciones. Consulta siempre las bases específicas de tu Comunidad Autónoma.

¿Qué Incluye este Curso Online?

No pagues más, por menos de lo que te ofrecemos, en el précio que te ofrece Universal Formación está Todo Incluido, incluso un posible puesto de trabajo junto a nuestro gran equipo.

Detalles Académicos y Generales del Curso

Todo lo que necesitas saber antes de inscribirte a este programa formativo: a quién va dirigido, cómo se organiza, qué metodología se sigue, los objetivos formativos, criterios de evaluación, competencias adquiridas y posibles salidas profesionales.

Datos Generales del Curso

Temario y contenidos del Curso Online

Módulo 1. Avances en Big Data para Ingenierías

Tema 1. Introducción

- ¿Qué es Big Data?

- Paradigmas de procesamiento en Big Data.

- Las 8 V de Big Data (Volumen, Volatilidad, Variedad, Valor, Velocidad, Variabilidad, Veracidad, Validez).

Tema 2. Batch processing

- MapReduce:

- Entorno MapReduce.

- Función Map y función Reduce.

- Flujo de datos.

- Características de MapReduce.

- Uso de MarpReduce.

- Ventajas e inconvenientes de Map Reduce.

- Ejercicios y ejemplos con MapReduce.

- Hadoop:

- Entorno Hadoop.

- Almacenamiento: HDFS.

- Características de HDFS.

- Apache Hadoop YARN:

- Funciones de Framework computacionales.

- YARN: El gestor de recursos del cluster.

- Conceptos de Apache Spark.

- Ejecución de Computational Frameworks en YARN.

- Exploración de las aplicaciones de YARN Applications a través de la Web UIs y de Shell.

- Agregación de los logs de YARN:

- Configuración de Hadoop y registros de Daemon.

- Localizar configuraciones y aplicar cambios de configuración.

- Gestión de instancias de Role y añadir servicios.

- Configuración del servicio HDFS.

- Configuración de los logs de Hadoop Daemon.

- Configuración del servicio YARN.

- Obtención de datos en HDFS:

- Ingestión de datos desde fuentes de recursos externos con Flume.

- Ingestión de datos desde bases de datos relacionales con Sqoop.

- REST Interfaces.

- Buenas prácticas para la importación de datos.

- Planificación de un cluster Hadoop:

- Consideraciones generales de planificación.

- Elección correcta de Hardware.

- Opciones de Virtualización.

- Consideraciones de red.

- Configuración de nodos.

- Instalación y configuración de Hive, Pig e Impala.

- Clientes Hadoop incluidos en Hue:

- ¿Qué es un cliente de Hadoop?

- Instalación y configuración de clientes Hadoop.

- Instalación y configuración de Hue.

- Autorizaciones y autenticación Hue.

- Configuración avanzada de un cluster:

- Parámetros avanzados de configuración.

- Configuración de puertos Hadoop.

- Configuración de HDFS para la organización en rack.

- Configuración de HDFS para obtención de alta disponibilidad.

- Seguridad Hadoop:

- ¿Por qué es importante la seguridad en Hadoop?

- Conceptos del sistema de seguridad de Hadoop.

- Qué es Kerberos y cómo funciona.

- Securización de un clúster Hadoop Cluster con Kerberos.

- Otros conceptos de seguridad.

- Gestión de recursos:

- Configuración de cgroups con Static Service Pools.

- El Fair Scheduler.

- Configuración de Dynamic Resource Pools.

- Configuraciones de CPU y memoria YARN.

- Impala Query Scheduling.

- Mantenimiento de un cluster:

- Chequeo del estado de HDFS.

- Copia de datos entre clústers.

- Añadir y eliminar de nodos en el clúster.

- Rebalanceo del Cluster.

- Directorio de Snapshots.

- Actualización del clúster.

- Solución de problemas y monitorización de un cluster:

- Sistema general de monitorización.

- Monitorización de clústers Hadoop.

- Solución de problemas habituales en el clúster de Hadoop.

- Errores habituales en la configuración.

Tema 3. Ciencia de datos

- Data Science:

- Que hacen los data scientists, herramientas y procesos que utilizan.

- Aplicación de lo aprendido en Tema 2: Uso de Hue.

- Apache Spark:

- Cómo trabaja Apache Spark y que capacidades nos ofrece.

- Que formatos de ficheros populares puede usar Spark para almacenar datos.

- Que lenguajes de programación puedes utilizar para trabajar con Spark.

- Cómo empezar a utilizar PySpark y Sparklyr.

- Cómo comparar PySpark y Sparklyr.

- Machine Learning:

- ¿Qué es machine learning?

- Algunos conceptos y términos importantes.

- Diferentes tipos de algoritmos.

- Librerías que se utilizan.

- Apache Spark MLlib:

- Que capacidades de machine learning nos proporciona MLlib.

- Cómo crear, validar y utilizar modelos de machine learning con MLlib.

- Ejecución de trabajos Apache Spark.

- Cómo un trabajo de Spark se compone de una secuencia de transformaciones seguida de una acción.

- Cómo Spark utiliza la ejecución lenta.

- Cómo Spark divide los datos entre las particiones.

- Cómo ejecuta Spark operaciones limitadas y grandes.

- Cómo Spark ejecuta un trabajo en tareas y fases.

Tema 4. Desarrollo para Spark y Hadoop

- Datasets y Dataframes

- Operaciones en Dataframe.

- Trabajar con Dataframes y Schemas.

- Crear Dataframes a partir de Data Sources.

- Guardar DataFrames en Data Sources.

- DataFrame Schemas.

- Rapidez y lentitud de ejecución.

- Análisis de datos con consultas de DataFrame:

- Consultar DataFrames con el empleo de expresiones de columna.

- Agrupación y agregación de consultas.

- Unión de DataFrames.

- RDD:

- Introducción RDD.

- RDD Data Sources.

- Creando y guardando RDDs.

- Operaciones con RDDs.

- Transformación de datos con RDDs:

- Escritura y paso de funciones de transformación.

- Ejecuciones de transformación.

- Conversión entre RDDs y DataFrames.

- Agregación de datos con Pair RDDs:

- Key-Valué Pair RDDs.

- Mal-Reduce.

- Otras operaciones Pair RDD.

- Consulta y vistas de tablas con Spark SQL:

- Datasets y DataFrames.

- Creación de Datasets.

- Ejecución y guardado de Datasets.

- Operaciones de Dataset.

- Creación, configuración y ejecución de aplicaciones Spark:

- Creación de una aplicación Spark.

- Compilar y ejecutar la aplicación.

- Application Deployment Mode.

- La interfaz Spark Application Web UI.

- Configuración de las propiedades de la aplicación.

- Procesamiento distribuido:

- Apache Spark en un Clúster.

- Particiones RDD.

- Ejemplo: Particionamiento en consultas.

- Etapas y Tareas.

- Planificación de tareas de ejecución.

- Persistencia de datos distribuidos:

- Persistencia en Datasets y DataFrames.

- Persistencia en niveles de almacenamiento.

- Visualización de RDDs persistentes.

- Patrones comunes al procesar datos con Spark:

- Casos comunes de uso de Spark.

- Algoritmos de iteración en Apache Spark.

- Machine Learning.

- Spark Streaming: Introducción a DStreams:

- Vista general de Spark Streaming.

- DStreams.

- Desarrollo de aplicaciones en Streaming.

- Spark Streaming: procesamiento de múltiples lotes:

- Operaciones Multi-Batch.

- Time Slicing.

- Operaciones de estado.

- Operaciones Sliding Window.

- Vista previa: Streaming estructurado.

- Apache Spark Streaming: Data Sources:

- Vista general de Streaming Data Source.

- Apache Flume y Apache Kafka Data Sources.

- Ejemplo: uso de un Kafka Direct Data Source.

Tema 5. Análisis de datos

- Introducción a Pig:

- ¿Qué es Pig?

- Características de Pig.

- Casos de empleo de Pig.

- Interacción con Pig.

- Análisis de datos básico con Pig:

- Sintaxis Pig Latin.

- Carga de datos.

- Tipos simples de datos.

- Definición de campos.

- Datos de salida.

- Vistas y esquemas.

- Filtrado y ordenación de datos.

- Funciones habituales.

- Procesado de datos complejos con Pig:

- Formatos de almacenamiento.

- Tipos de datos complejos y anidados.

- Agrupaciones.

- Funciones predefinidas para datos complejos.

- Iteración de datos agrupados.

- Operaciones con multiconjuntos de datos con Pig:

- Técnicas para combinar conjuntos de datos.

- Unión de conjuntos de datos con Pig.

- Conjunto de operaciones.

- División de conjuntos de datos.

- Troubleshooting y optimización de Pig:

- Troubleshooting en Pig.

- Inicio de sesión.

- Empleo de UI web Hadoop.

- Muestreo de datos y depuración.

- Visión general del rendimiento.

- Comprensión del plan de ejecución.

- Consejos para mejorar el rendimiento de Jobs en Pig.

- Introducción a Hive e Impala:

- ¿Qué es Hive?

- ¿Qué es Impala?

- ¿Por qué utilizar Hive e Impala?

- Schema y almacenamiento de datos.

- Comparación entre Hive y bases de datos tradicionales.

- Casos de uso.

- Consultas con Hive e Impala:

- Tablas y bases de datos.

- Sintaxis básica en consultas Hive e Impala.

- Tipos de datos.

- Empleo de Hue para ejecutar consultas.

- Empleo de Beeline (la Shell de Hive).

- Empleo de la Shell de Impala.

- Administración de datos:

- Almacenamiento de datos.

- Creación de bases de datos y tablas.

- Carga de datos.

- Alteración de bases de datos y tablas.

- Simplificación de consultas con vistas.

- Almacenamiento de resultados de consultas.

- Almacenamiento y datos de rendimiento:

- Partición de tablas.

- Carga de datos en tablas particionadas.

- Cuándo utilizar el particionamiento.

- Elección de formato de almacenamiento.

- Gestión de metadatos.

- Control de acceso a datos.

- Análisis de datos relacional con Hive e Impala:

- Unión de conjuntos de datos.

- Funciones predefinidas habituales.

- Agregaciones y Windowing.

- Datos complejos con Hive e Impala:

- Datos complejos con Hive.

- Datos complejos con Impala.

- Análisis de texto con Hive e Impala:

- Empleo de expresiones regulares.

- Procesamiento de texto con SerDes en Hive.

- Análisis de los sentimientos y N•Grams.

- Optimización Hive:

- Rendimiento de las consultas.

- Bucketing.

- Indexación de datos.

- Hive en Spark.

- Optimización de Impala:

- Ejecución de consultas.

- Mejorar el rendimiento de Impala.

- Extendiendo Hive e Impala:

- Customizar SerDes y formatos de fichero en Hive.

- Transformación de datos con Scripts personalizados en Hive.

- Funciones definidas por el usuario.

- Consultas parametrizadas.

- Comparación entre MapReduce, Pig, Hive, Impala, y bases de datos relacionales. ¿Cuál elegir?

Módulo 2. Aplicación Teórico-Práctica de Big Data para Ingenierías (opcional)

En este módulo final, se te invita a emprender un ejercicio de desarrollo enfocado en una de las temáticas que has estudiado previamente o alguna temática de innovación relacionada directamente con Big Data para Ingenierías. Durante la realización de este ejercicio, tendrás a tu disposición en el Campus Virtual una serie de documentos que funcionarán como guías y ejemplos para ayudarte en tu tarea. Más importante aún, contarás con el apoyo constante y sincrónico de nuestro equipo docente, quienes estarán disponibles para asistirte y resolver cualquier duda o inquietud que pueda surgir mientras avanzas en tu proyecto. Este ejercicio representa una oportunidad valiosa para aplicar y consolidar los conocimientos adquiridos a lo largo del curso.

Formaciones relacionadas con el Curso Universitario de Especialización en Big Data para Ingenierías

Curso Universitario de Especialización en Big Data

Curso Arquitectura Técnica acreditado por EUNEIZ

Curso de Desarrollo Profesional en Avances en Big Data

Curso Arquitectura Técnica acreditado por UTAMED

Curso de Desarrollo Profesional en Oracle para Datamining y Big Data

Curso Arquitectura Técnica acreditado por UTAMED

Curso de Desarrollo Profesional en Oracle Data Warehouse: Datamining y Big Data

Curso Arquitectura Técnica acreditado por UTAMED

Solicita información